こちらの記事からの続きです。

ストラテジ系についてはこちら

テクノロジ系の改訂箇所

続いて、テクノロジ系の改訂箇所を見ていきましょう。テクノロジ系では新しい用語の追加が中心となっています。

●大分類7:基礎理論/中分類13:基礎理論/35. 情報に関する理論

(5)AI(Artificial Intelligence:人工知能)の技術

・AI技術(自然言語処理,音声・画像(静止画・動画)の認識・合成など)の基本的な考え方,仕組み,基盤モデル,特徴

【用語例】

過学習,事前学習,ファインチューニング,転移学習,畳み込みニューラルネットワーク(CNN),再帰的ニューラルネットワーク(RNN),敵対的生成ネットワーク(GAN),大規模言語モデル(LLM),プロンプトエンジニアリング

えーい、小難しい! 正直、CNN、RNN、GANあたりはITパスポート試験で問う必要があるのか疑問です。でも、しょうがないから解説します。

■過学習

AIが学習に使った訓練データに対しては精度が高い結果となる一方で、未知のデータに対しては精度が下がる現象を過学習といいます。過学習になると、AIとしての汎用性がなくなってしまいます。

※令和4年秋期応用情報午前問4の選択肢イより

■事前学習

AIに関する研究開発が進む中で、AIも人間のようにベースとなる知識があった上で専門領域を学習した方が精度が上がり、かつ計算量も削減できることが分かってきました。この、「ベースとなる知識」を用意するために行う機械学習を事前学習といいます。ここで生成した学習済みモデルは、ファインチューニングや転移学習などで利用されます。

■ファインチューニング

ある領域で学習した学習済みモデルに、より高度な学習データを与えるなどして追加で学習させ、AIの精度をより高めるための調整(チューニング)を行うことです。

■転移学習

ある領域で学習した学習済みモデルを、別の領域に再利用することによって、効率的に学習させることを転移学習といいます。

※令和4年秋期応用情報午前問4の選択肢アより

■畳み込みニューラルネットワーク(CNN)

深層学習の一種で、画像解析などでよく利用されています。畳み込みというのは、入力データにフィルターをかけて数値に変換していく処理で、CNNでは多数の畳み込み層によって特徴を抽出して学習データを生成します。

■再帰的ニューラルネットワーク(RNN)

深層学習の一種で、自然言語処理などでよく利用されています。再帰的な構造をもち、ある時点の入力を受けて出力を計算しなおすといった形で、入力に沿った予測を行うことができます。

■敵対的生成ネットワーク(GAN)

教師なし学習で使用されるアルゴリズムの一種で、生成側と識別側の2つのニューラルネットワークを配置して学習を行う特徴があります。生成側は識別側を騙そうとし、識別側は正しく評価するようにトレーニングします(だから“敵対的”なんですね)。

■大規模言語モデル(LLM)

これまた読んで字のごとく、大規模な言語モデルのことです。言語モデルというのは、日本語のような自然言語をコンピュータで扱いやすいように構造化し、単語はもちろん文法や品詞といった使われ方に関する情報などを集積したものです。いま流行りのChatGPTのベースとなっているGPTやBERTなどがLLMの代表例です。

■プロンプトエンジニアリング

生成AIがこちらの意図に沿った回答を生成できるように、AIに入力する命令(プロンプト)を構築する技術のこと。AIから上手に情報を引き出す技術、と言い換えてもいいかもしれません。AIの特性を考慮して聞きだす段取りを考えるなどします。

●大分類9:技術要素/中分類23:セキュリティ/61. 情報セキュリティ

(4)攻撃手法

【用語例】

・プロンプトインジェクション攻撃,敵対的サンプル(Adversarial Examples)

最後にセキュリティ分野です。ここも用語の追加がありました。

■プロンプトインジェクション攻撃

インジェクションとは注射のことで、情報セキュリティにおいては「システムに受け渡す入力文に対して、悪意のあるコードを注入(挿入)する攻撃」を指してインジェクション攻撃といいます。代表例にSQLインジェクションがあります。これはデータベースに受け渡すSQL文に悪意のあるコードを含ませて、本来なら引き出せないデータを引き出すなど、システム側が意図しない動作を引き起こす攻撃です。

プロンプトインジェクションの場合は、生成AIに入力する命令(プロンプト)が攻撃対象となります。意図しないコンテンツを生成させたり、学習データやプロンプト自体の盗難、意図しない動作を引き起こすことが懸念されています。

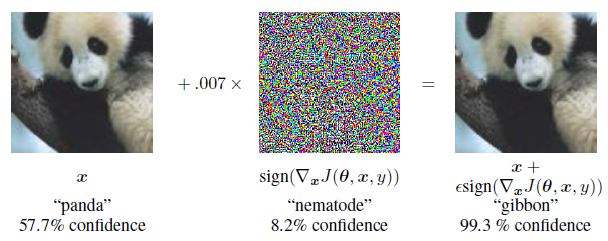

■敵対的サンプル(Adversarial Examples)

学習済みのAIモデルを騙す目的で作成された素材のこと。攻撃対象のAIモデルに意図的にノイズを加えた敵対的サンプルを繰り返し学習させることで、AIは新たな特徴を学び、それによって騙されるようになります(ここで加えられたノイズのことを摂動といいます)。

人にとっては意味のない素材もあれば、下の画像の例のように、元の素材との違いが判別しにくいものもあります。なお、ネットで検索すると画像の事例が多いですが、AIに学習させたものであれば何でも対象となります(例えば音声など)。

出典:「Explaining and Harnessing Adversarial Examples」Figure 1/Ian J. Goodfellow, Jonathon Shlens & Christian Szegedy

https://arxiv.org/abs/1412.6572

おわりに

いかがでしたか。更新された内容は生成AI関連一色でしたね。「説明可能なAI」という用語もありましたが、AIを説明すること自体が難しいので、ITパスポート試験でどのように出題してくるのか、気になるところです。

8月下旬に公表されるというサンプル問題についても解説する予定です。お楽しみに!